AI 기반의 멀티모달 번역 시스템 “SeamlessM4T”으로 세계 언어 소통의 장벽을 허물다

세계는 점점 더 연결되어 있습니다. 인터넷, 모바일 기기, 소셜 미디어, 통신 플랫폼의 글로벌 보급은 사람들에게 이전보다 더 다양한 언어로 된 콘텐츠에 접근할 수 있게 해주었습니다. 이와 같은 맥락에서 언어를 실시간으로 소통하고 정보를 이해하는 능력은 점점 더 중요해지고 있습니다. 이 능력은 오랜 시간 동안 과학 소설에서만 꿈꾸어온 것이었지만, 인공지능은 이 비전을 기술적 현실로 이끌어내려는 경계에 서 있습니다.

우리는 공개적으로 과학 연구에 대한 접근을 촉진하기 위해 SeamlessM4T를 CC BY-NC 4.0으로 공개적으로 출시하고 있습니다. 이를 통해 연구원과 개발자들이 이 작업을 기반으로 더 나은 시스템을 구축할 수 있도록 돕고 있습니다. 우리는 또한 세계에서 가장 큰 오픈형 다중모달 번역 데이터셋인 SeamlessAlign의 메타데이터를 공개적으로 출시하고 있습니다. 이 데이터셋은 총 27만 시간에 달하는 음성과 텍스트의 정렬 정보를 포함하고 있습니다. 우리는 SONAR라고 하는 완전한 음성 및 텍스트 문장 인코더 스위트와 멀티모달 데이터 처리 및 병렬 데이터 마이닝을 위한 라이브러리인 stopes를 사용하여 커뮤니티가 자체 단일 언어 데이터셋에서 마이닝을 수행할 수 있도록 지원하고 있습니다. 모든 연구 진전은 다음 세대 시퀀스 모델링 라이브러리인 fairseq2를 통해 지원됩니다.

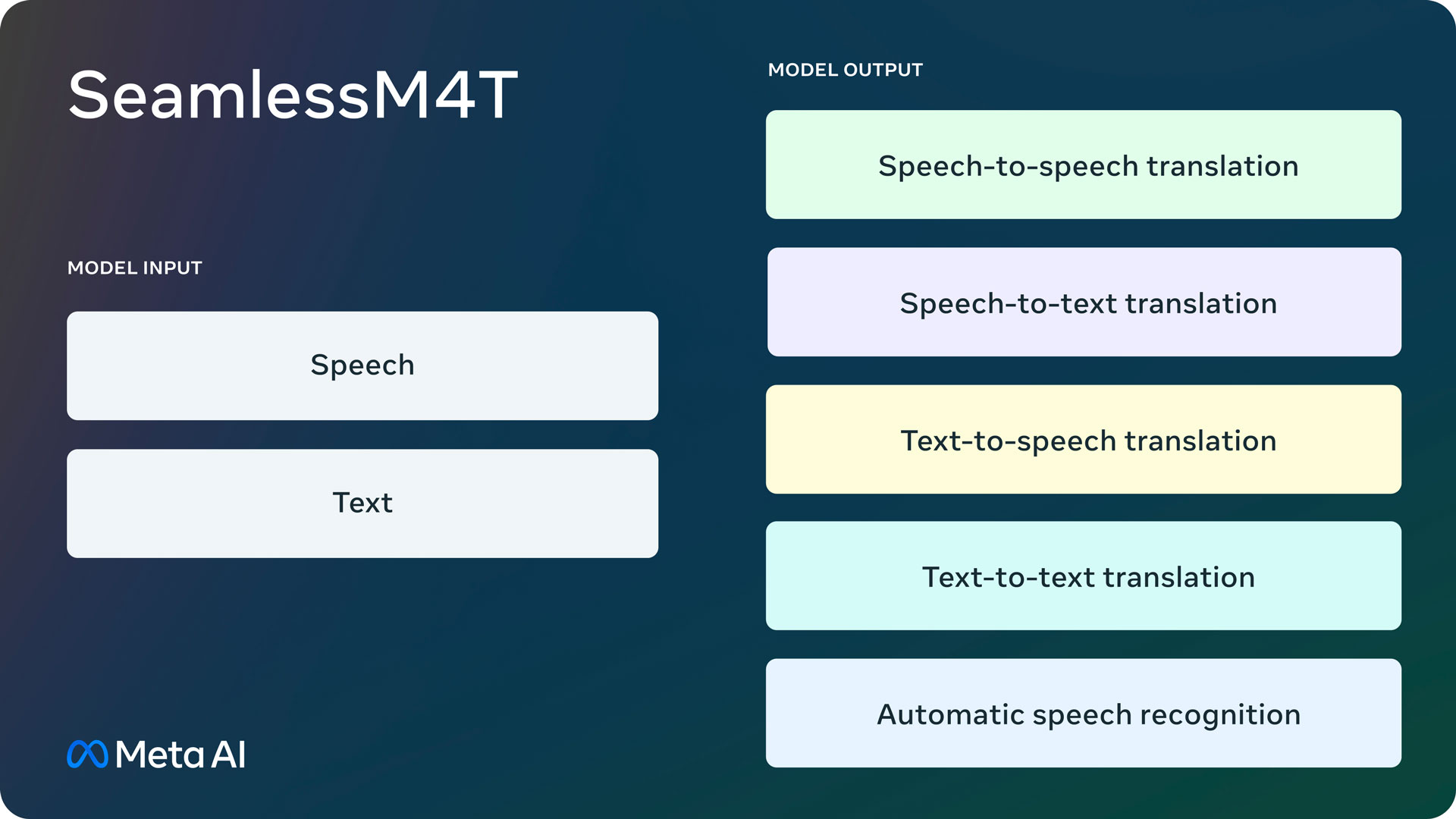

소위 ‘바벨 피쉬’와 같은 통합 언어 번역기를 만드는 것은 어려운 과제입니다. 기존의 음성-음성 및 음성-텍스트 시스템은 세계의 언어 중 일부만 지원합니다. SeamlessM4T는 제한된 언어 지원과 별도의 시스템에 의존하는 문제를 해결하여 음성-음성 및 음성-텍스트 분야에서 혁신적인 발전을 이루었습니다. 이러한 시스템은 대량의 데이터를 활용하고 일반적으로 한 가지 모달리티에서만 우수한 성능을 발휘합니다. 우리의 과제는 모든 기능을 수행할 수 있는 통합된 다국어 모델을 만드는 것이었습니다.

오늘 발표하는 작업이 이 여정에서 큰 발전이라고 믿습니다. 우리의 단일 모델은 서로 다른 언어를 사용하는 사람들이 보다 효과적으로 소통할 수 있는 실시간 번역을 제공합니다. 우리는 지원하는 적은 양의 디지털 언어 자료가 있는 저·중규모 언어의 성능을 크게 향상시켰습니다. 또한 영어, 스페인어, 독일어와 같은 고양이 언어에서 강력한 성능을 유지합니다. SeamlessM4T는 별도의 언어 식별 모델 없이도 원문 언어를 암묵적으로 인식합니다.

우리는 이번 작업이 Meta와 기타 연구진들이 범례적인 번역기를 만들기 위해 지난 몇 년 동안 한 발자국씩 나아가는 데에 기여한다고 믿습니다. 작년에 우리는 200개 언어를 지원하는 텍스트-텍스트 기계 번역 모델인 No Language Left Behind(NLLB)를 공개하였으며, 이 모델은 후키엔(Hokkien)이라는 널리 사용되지 않는 언어의 첫 번째 직접 음성-음성 번역 시스템인 Universal Speech Translator의 데모를 공유하였습니다. 이를 통해 우리는 대규모 멀티모달 음성-음성 번역 데이터셋인 SpeechMatrix와 전체적인 학습을 위한 획기적인 지도 학습 기반 SpeechLASER를 개발하였습니다. 올해 초에는 1,100개 이상의 언어에 걸친 자동 음성인식, 언어 식별 및 음성 합성 기술을 제공하는 Massively Multilingual Speech를 공유하였습니다. SeamlessM4T는 이러한 프로젝트들의 결과를 활용하여 단일 모델에서 파생된 다국어 및 멀티모달 번역 경험을 제공합니다.

우리의 접근 방식

통합 모델을 구축하기 위해서는 가벽이 낮고 현대적인 PyTorch 생태계 라이브러리와 쉽게 조합할 수 있는 시퀀스 모델링 툴킷인 fairseq를 재설계하였습니다. fairseq2는 더 효율적인 모델링과 데이터 로더 API를 통해 SeamlessM4T의 모델링을 강화하는 데 도움을 주었습니다.

모델로는 다국어 텍스트 및 음성을 직접 생성할 수 있는 multitask UnitY 모델 아키텍처를 사용합니다. 이 새로운 아키텍처는 이미 기존의 UnitY 모델에 포함된 automatic speech recognition, text-to-text, text-to-speech, speech-to-text, speech-to-speech 번역을 지원하며, 텍스트 및 음성 인코더는 거의 100개 언어의 음성 입력을 인식하는 역할을 합니다. 텍스트 디코더는 그 의미를 텍스트로 번역하여 거의 100개 언어로 출력하고, 텍스트-유닛 모델은 36개 언어의 이산 음향 유닛으로 디코딩합니다. 자기 지도 학습 인코더, 음성-텍스트, 텍스트-텍스트 번역 구성요소 및 텍스트-유닛 모델은 모델의 품질과 훈련의 안정성을 개선하기 위해 사전 학습되었습니다. 디코딩된 이산 유닛은 다국어 HiFi-GAN unit vocoder를 사용하여 음성으로 변환됩니다.

음성 인코더가 음성을 처리하는 방법

우리의 자기 지도 학습 음성 인코더인 w2v-BERT 2.0은 w2v-BERT의 훈련 안정성과 표현력을 개선한 개선 버전입니다. 이 인코더는 수백만 시간의 다국어 음성을 분석하여 음성에서 구조와 의미를 찾아냅니다. 인코더는 오디오 신호를 받아서 작은 부분으로 나누고, 말하는 내용의 내부적인 표현을 구축합니다. 말로 된 단어들은 여러 소리와 문자로 구성되기 때문에 이를 실제 단어로 대략적으로 매핑하기 위해 길이 조정기를 사용합니다.

텍스트를 처리하는 방법

마찬가지로, 우리는 NLLB 모델을 기반으로 한 텍스트 인코더를 가지고 있습니다. 이 인코더는 거의 100개 언어의 텍스트를 이해하고 번역에 유용한 표현을 생성할 수 있도록 훈련되었습니다.

텍스트 생성

우리의 텍스트 디코더는 인코딩된 음성 표현 또는 텍스트 표현을 입력으로 받아들입니다. 이는 자동 음성인식과 같은 동일한 언어의 작업에 적용될 수 있으며, 멀티모달 번역 작업에도 활용될 수 있습니다. 예를 들어, 누군가가 프랑스어로 “bonjour”라는 단어를 말하면 스와힐리어로 번역된 텍스트 “habari”를 예상할 수 있습니다. 멀티태스크 학습을 통해 강력한 텍스트-텍스트 번역 모델(NLLB)의 장점을 활용하여 토큰 수준의 지식 전달을 통해 음성-텍스트 번역 모델을 안내합니다.

음성 생성

우리는 대상 언어에서 음성을 나타내기 위해 음향 유닛을 사용합니다. UnitY 모델의 텍스트-유닛(T2U) 구성요소는 이산 음향 유닛을 생성하며, UnitY 세부 조정 전에 ASR 데이터로 사전 학습되었습니다. 그런 다음 멀티언어 HiFi-GAN unit vocoder를 사용하여 이 이산 유닛을 오디오 파형으로 변환합니다.

데이터 확장

SeamlessM4T와 같은 데이터 주도 모델은 대량이고 고품질의 엔드 투 엔드 데이터, 즉 음성-텍스트 및 음성-음성 데이터에 크게 이점을 얻습니다. 인간이 직접 전사하고 번역한 음성만 사용하는 것은 100개 언어에 대한 음성 번역이라는 어려운 과제를 해결하기에 충분하지 않습니다. 우리는 유사성 척도를 사용하여 공동 임베딩 공간에서 유사한 문장을 찾는 텍스트-텍스트 마이닝에 대한 선도적인 연구와 음성 마이닝에 대한 초기 작업을 기반으로 추가 리소스를 만들기 위해 노력하였습니다.

먼저, 우리는 200개 언어에 대한 새로운 대규모 다국어 및 -모달 텍스트 임베딩 공간인 SONAR(Sentence-level mOdality- and laNguage-Agnostic Representations)를 구축하였으며, 이는 LASER3나 LaBSE와 같은 기존 접근법보다 훨씬 우수한 성능을 발휘합니다. 그런 다음 선생-학생 접근법을 적용하여 이 임베딩 공간을 음성 모달리티로 확장시켜 현재 36개 언어에 대응할 수 있도록 하였습니다. 마이닝은 공개적으로 제공되는 웹 데이터(수십억 개 문장) 및 음성(400만 시간) 리포지토리에서 수행되었습니다. 총 44만 3000 시간 이상의 음성과 텍스트를 자동으로 정렬하고 약 2만 9000 시간의 음성-음성 정렬을 만들었습니다. 이 데이터셋인 SeamlessAlign은 전체 양과 언어 커버리지 측면에서 열린 음성/음성 및 음성/텍스트 병렬 코퍼스 중 가장 큰 데이터셋입니다.

결과

SeamlessM4T는 거의 100개 언어에 대한 state-of-the-art 결과와 자동 음성인식, 음성-텍스트, 음성-음성, 텍스트-음성, 텍스트-텍스트 번역 등 다중태스크 지원을 단일 모델에서 제공합니다. 지원되는 작업과 언어에 따라서 저·중규모 언어의 성능을 크게 개선했으며 고양이 언어에서 강력한 성능을 유지합니다.

문자 기반 평가 지표에 의존하지 않고 시스템을 보다 정확하게 평가하기 위해 우리는 이전의 text-less metric를 BLASER 2.0으로 확장시켰습니다. BLASER 2.0은 이전 버전과 비교하여 유사한 정확도로 음성 및 텍스트 유닛 사이에서 평가할 수 있게 해줍니다. 견고성에 대한 테스트에서 우리의 시스템은 현재 최신 기술 모델에 비해 음성-텍스트 작업에서 배경 잡음과 화자 변동에 대해 더 나은 성능을 발휘합니다(각각 평균 개선률 37% 및 48%).

SeamlessM4T는 이전의 state-of-the-art 경쟁 모델보다 뛰어난 성능을 보입니다.

SeamlessM4T를 책임있게 구축하기

번역 시스템이 정확해야 한다는 것은 매우 중요합니다. AI 시스템과 마찬가지로, 모델이 사용자가 원하는 바를 잘못 전달하거나 유해하거나 부정확한 출력물을 생성할 위험이 있습니다.

Meta에서는 Responsible AI의 다섯 가지 원칙에 따라 책임 있는 프레임워크로 AI 연구와 개발을 진행하고 있습니다. 책임 있는 AI에 대한 우리의 약속에 따라 독성 및 편견에 대한 연구를 수행하여 모델의 민감한 부분을 파악하는 데 도움이 되었습니다. 독성에 대해서는 말 입력과 출력에서 독성 단어를 식별하기 위해 매우 다국어적인 독성 분류기를 확장하였습니다. 균형 잡히지 않은 독성은 훈련 데이터에서 필터링하였습니다. 입력 또는 출력에 서로 다른 독성 비율이 포함된 경우 해당 학습 쌍을 제거하였습니다.

오늘 공개하는 데모는 SeamlessM4T의 기능을 보여주기 위한 중요한 연구 결과입니다. 데모에서 우리는 입력과 출력 모두에서 독성을 감지합니다. 출력에서만 독성이 감지되면 독성이 추가된 것입니다. 이 경우 경고 메시지를 포함시키고 출력물을 보여주지 않습니다. 모델과 최신 기술 모델과 비교할 때, 우리는 음음 번역 및 음성-텍스트 번역에서 추가된 독성을 크게 줄였습니다.

또 다른 평등 문제인 결과가 불공정하게 한 성별을 선호하거나 종종 성별 스테레오 타입으로 기본 설정되는 성별 편견도 점점 규모잡아 평가하기 시작하는 영역입니다. 우리는 이제 이전에 설계된 Multilingual HolisticBias 데이터셋을 확장하여 수십 개의 음성 번역 방향에서 성별 편견을 정량화할 수 있게 되었습니다.

안전과 보안에 대한 우리의 작업은 계속되고 있습니다. 우리는 SeamlessM4T를 계속해서 개선하고 모델에서 발생하는 독성 사례들을 줄일 수 있도록 이 분야에서 연구하고 조치할 것입니다.

기술에 대한 접근 제공

우리는 최첨단 결과를 바탕으로 SeamlessM4T가 AI 커뮤니티가 범용적인 멀티태스크 시스템을 만드는 데 중요한 진전이라고 믿습니다. 우리의 오픈 사이언스 접근 방식에 따라, 연구원과 개발자들이 이 기술 위에 새로운 시스템을 구축할 수 있도록 우리의 모델을 공개적으로 공유하는 것에 기대감을 가지고 있습니다.

이것은 다양한 언어 간의 연결을 돕는 AI 기반 기술을 구축하기 위한 우리 지속적인 노력 중 최신 단계입니다. 앞으로 이 기반 모델이 어떻게 새로운 소통 기능을 가능하게 할 수 있는지 탐색해 보고자 합니다. 그 결과로 모든 사람들이 서로 이해할 수 있는 세계에 한 걸음 더 가까워질 수 있는 세상으로 가보길 바랍니다.

코드, 모델 및 데이터 다운로드

본 블로그 포스트는 Bapi Akula, Pierre Andrews, Can Balioglu, Loïc Barrault, Onur Çelebi, Peng-Jen Chen, Yu-An Chung, Mariano Cora Meglioli, David Dale, Ning Dong, Paul-Ambroise Duquenne, Naji El Hachem, Maha Elbayad, Brian Ellis, Hady Elsahar, Cynthia Gao, Hongyu Gong 등의 연구진들의 노력으로 가능해진 것입니다.

-------------------------------

데모는 약 100개의 입력 언어와 35개의 출력 언어로의 번역을 지원하는 연구 데모입니다.

사용 방법은 다음과 같습니다:

- 조용한 환경에서 원하는 언어로 한 문장을 말하고 녹음하세요.

- 문장을 번역할 언어를 최대 3개까지 선택하세요.

- 번역문을 듣고 문장의 음성 인식 내용을 확인하세요.

제한 사항으로 이 데모는 실험적인 연구 데모입니다. 정확하지 않은 번역이나 원문의 의미가 변경된 번역이 나올 수 있습니다. 문제가 발견되면 피드백 기능을 통해 알려주시면 모델 개선에 도움이 됩니다.

테스트해보기

Discussions (0)

관련 블로그